Tu web va lenta. Las analíticas muestran un tráfico extraño que no convierte. Tu factura de hosting sube sin que aumenten tus clientes reales. Antes de culpar a tu servidor o a tu proveedor, tienes que hacerte una pregunta: ¿Quién está visitando realmente mi web?

Imagina que tu servidor es un restaurante. Googlebot y Bingbot son clientes VIP que vienen a comer, dejan buenas reseñas y atraen a más gente. Pero por la puerta de atrás se te está colando una multitud de «gorrones»: bots que no piden nada, ocupan todas las mesas, se beben toda el agua, entran hasta la cocina y ralentizan el servicio para tus clientes de verdad.

Estos bots «malos» o «inútiles» están consumiendo tu CPU, tu RAM y tu ancho de banda. Están matando el rendimiento de tu servidor y, en consecuencia, tu SEO y la experiencia de tus usuarios.

Hoy vamos a convertirnos en los porteros de nuestra propia discoteca. Con los logs del servidor como lista de invitados, vamos a identificar a los gorrones y a echarlos de una vez por todas.

Los buenos, los pesados y los malos: conoce a tus visitantes robóticos

No todos los bots son iguales. Antes de empezar a bloquear a diestro y siniestro, hay que saber distinguirlos.

- Los bots buenos (Los VIPs): Son los rastreadores de los motores de búsqueda que te traen tráfico. Googlebot, Bingbot, DuckDuckGoBot. Son transparentes, se identifican claramente y, por lo general, respetan las reglas de tu

robots.txt. A estos les pones una alfombra roja. - Los bots «pesados» pero Legítimos (comerciales, herramientas…): Son rastreadores de herramientas SEO conocidas. AhrefsBot, SemrushBot, MJ12bot (Majestic), Moz. No te traen tráfico directo, pero los usan herramientas que tú (u otros) podéis utilizar. A veces son demasiado agresivos, pero suelen ser «educados»: si les pides en tu

robots.txtque aflojen, lo hacen. - Los bots malos e inútiles: Son la plaga. No aportan absolutamente nada y solo consumen recursos. Aquí entran muchos tipos:

- Scrapers de contenido: Bots que copian tu web para plagiarla.

- Scanners de vulnerabilidades: Buscan fallos de seguridad para hackearte.

- Bots de scraping de precios, emails o datos.

- Rastreadores de motores de búsqueda minoritarios y sin relevancia para tu negocio (Yandex, Baidu si tu público no es ruso o chino). PetalBot (Huawei), AspiegelBot, Bytespider.

- Scrapers de contenido: Bots que copian tu web para plagiarla.

La prueba del delito: identificando a los culpables en tus logs

Manos a la masa. Vamos a ver quiénes son los que más recursos consumen. Con este simple comando, sacaremos un ranking de los «visitantes» (por su User-Agent) que más peticiones hacen a tu servidor.

# Extrae el User-Agent de cada petición, los cuenta y ordena de mayor a menor

awk -F'"' '{print $6}' access.log | sort | uniq -c | sort -nr | head -30

Nota: Este comando asume un formato de log estándar. El User-Agent es el sexto campo ($6) cuando dividimos la línea por comillas (").

Ahora, mira tu resultado. Verás algo parecido a esto:

250120 Googlebot/2.1

180500 PetalBot/1.0

150310 Bytespider

90850 Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/)

85400 Mozilla/5.0 (Linux; Android 7.0;) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/100.0.4896.127 Mobile Safari/537.36

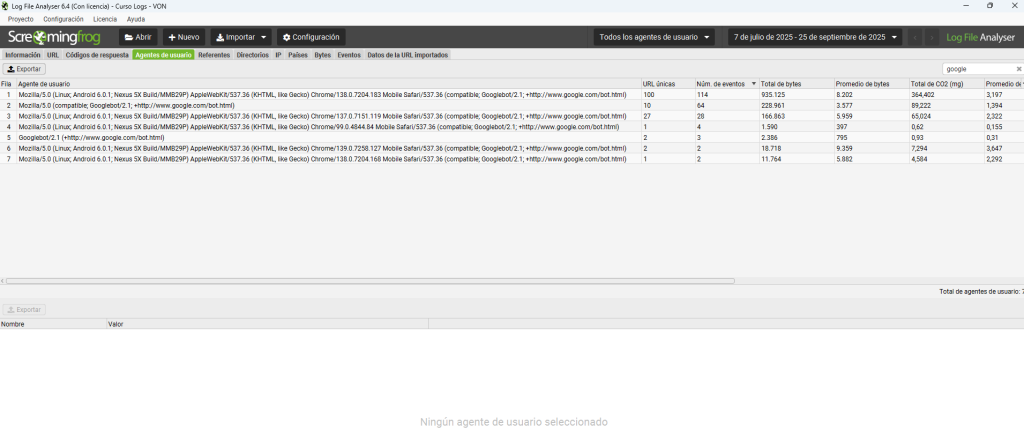

...¿No te llevas bien con los comandos? No problem, tenemos el Log File Analyser de Screaming Frog, si quieres aprender más sobre logs te espero en mi canal de Youtube.

Análisis del resultado:

- Googlebot: Es normal que esté el primero. Es nuestro cliente VIP.

- La línea de «Mozilla…»: Es un visitante humano normal desde un móvil Chrome.

Otros bots que podemos encontrar:

PetalBot y Bytespider: Dos bots que hacen cientos de miles de peticiones y que, si tu negocio no se enfoca en el buscador de Huawei o en el mercado asiático, no te aportan NADA. Son los gorrones número uno.

AhrefsBot: Es un bot «pesado». Si usas Ahrefs o te interesa que otros te analicen, quizás quieras dejarlo, pero puedes pedirle que baje el ritmo.

Hazte estas preguntas para cada bot sospechoso:

- ¿Sé quién es? (Búscalo en Google).

- ¿Me aporta algún valor? (¿Es un buscador que me trae tráfico? ¿Una herramienta que uso?).

- ¿Es demasiado agresivo? (¿Su número de peticiones es desproporcionado?).

Si la respuesta es «no me aporta valor y es muy agresivo», entonces está en la lista negra.

«No puedes pasar»: guía de bloqueo de menos a más efectivo

Ya tenemos los nombres. Ahora vamos a enseñarles la puerta de salida.

Nivel 1: La petición amable (robots.txt)

Este método solo funciona para los bots «pesados» pero legítimos que son educados y leen las reglas.

# Para pedirle a Ahrefs que venga más despacio (una petición cada 10 segundos)

User-agent: AhrefsBot

Crawl-delay: 10

# Para bloquear directamente a un bot educado

User-agent: MJ12bot

Disallow: /

Efectividad: Alta para bots legítimos, NULA para bots malos. Los gorrones no leen las normas de la casa.

Nivel 2: El portero de discoteca (.htaccess)

Ahora nos ponemos serios. Con esto, bloqueamos al bot a nivel de servidor. La petición ni siquiera llegará a tu web. Es mucho más eficiente.

Abre tu archivo .htaccess (en servidores Apache/LiteSpeed) y añade esto:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} PetalBot|Bytespider|AspiegelBot [NC]

RewriteRule .* - [F,L]

Explicación:

RewriteCond: Es la condición. Si el User-Agent (%{HTTP_USER_AGENT}) contienePetalBotOBytespiderOAspiegelBot… ([NC]significa que no distingue mayúsculas/minúsculas).RewriteRule: Es la acción. Deniega el acceso ([F]de Forbidden) y deja de procesar más reglas ([L]de Last).

Efectividad: Muy alta. La mayoría de los bots malos caerán aquí. Su único truco es cambiar de User-Agent, pero muchos no lo hacen.

Nivel 3: El muro de seguridad (Cloudflare o Firewall)

Este es el método definitivo y el más recomendado.

La opción fácil y gratis: Cloudflare. Si usas Cloudflare, puedes crear reglas de firewall para bloquear bots de forma muy sencilla.

- Ve a

Security > WAF > Firewall Rules. - Crea una regla:

If (User-Agent contains "PetalBot") then Block. - Activa el modo «Bot Fight Mode» de Cloudflare, que detecta y bloquea automáticamente a muchos de estos bots sin que tengas que hacer nada.

Por cierto que Cloudflare ya permite por defecto bloquear los bots de las IAs y LLMs de forma muy sencilla por si quieres usar esta función.