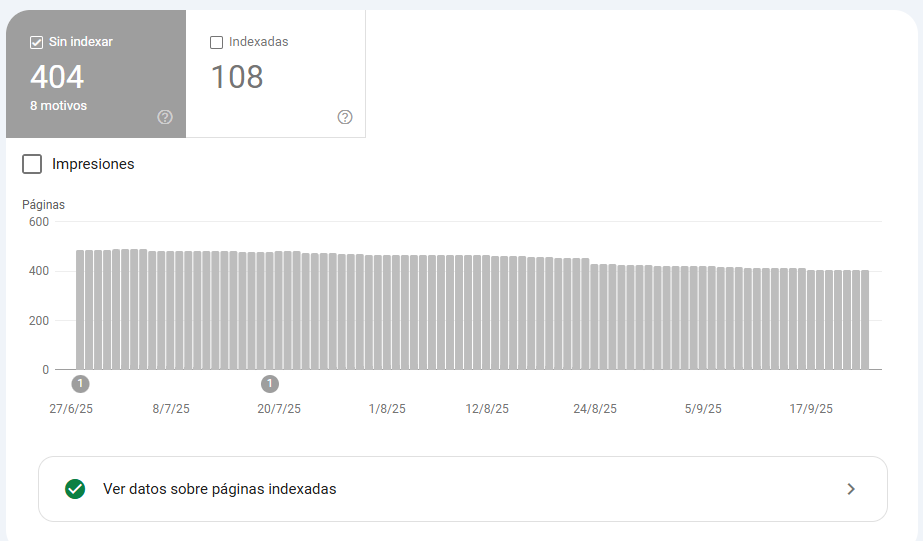

Publicas contenido nuevo, lo mimas, lo enlazas y esperas. Pero pasan las semanas y Google Search Console te devuelve el mismo mensaje desolador: «Detectada, pero sin indexar actualmente» o, peor aún, «No se ha encontrado en Google».

Es como organizar una fiesta increíble, enviar las invitaciones y darte cuenta de que el invitado de honor, Googlebot, ni siquiera se ha presentado.

[Por cierto, tenemos en la academia un Curso completo de Google Search Console para que aprendas a dominarlo en pocas horas]

Search Console te dice el qué, pero los logs de tu servidor te cuentan el porqué. Son la caja negra de tu web, el vídeo de seguridad que te muestra si Googlebot llegó a la puerta, si encontró la puerta cerrada, si entró y se fue corriendo, o si directamente se perdió por el camino.

Hoy vamos a dejar de adivinar y vamos a ponernos el mono de trabajo. Vamos a usar los logs para entender qué demonios está haciendo Googlebot en nuestra web y por qué no le da la gana de indexar esas URLs que son cruciales para el negocio.

Antes de abrir los logs: descarta a los sospechosos habituales

No todos los problemas de indexación requieren un análisis forense. Antes de sumergirte en la consola, asegúrate de que no te estás auto-saboteando. Revisa esto en 5 minutos:

- Meta etiqueta

noindex: ¿Has dejado por error unmeta name="robots" content="noindex"en la página? El Inspector de URLs de GSC te lo chiva al instante. - Bloqueo en

robots.txt: ¿Hay alguna reglaDisallowque esté impidiendo el acceso a la URL o a sus recursos (CSS, JS)? - Canonicalización incorrecta: ¿La URL tiene una etiqueta

canonicalapuntando a otra página? Si es así, le estás diciendo a Google que la ignore y que indexe la otra.

Si todo esto está correcto, pero la página sigue en el limbo, es hora de arremangarse. Bienvenidos a los logs.

[Oye que si los logs se te atragantan estoy preparando un curso completo sobre logs orientado a SEO muy práctico y para empezar desde cero, ¡no hay excusas!]

Los 3 patrones de Googlebot que explican por qué no te indexa

Cuando analizamos los logs de un cliente con problemas de indexación, buscamos uno de estos cuatro dramas. Cada uno tiene una causa y una solución muy diferente.

1. El fantasma: Googlebot ni siquiera visita tus nuevas URLs

Este es el más frustrante. Creas contenido, pero en los logs no hay ni rastro de que Googlebot haya pasado por ahí.

El porqué: Tu presupuesto de rastreo (Crawl Budget) se está malgastando. Googlebot tiene un tiempo limitado para tu web y lo está perdiendo en un laberinto de URLs basura en lugar de encontrar tu contenido nuevo y valioso.

Cómo se ve en los logs: Verás miles de peticiones de Googlebot a URLs que no aportan nada:

- Filtros de búsqueda facetada (

/buscar?color=rojo&talla=m&...) - Parámetros de seguimiento (

?utm_source=...,?gclid=...) - Cadenas de redirecciones 301 interminables.

- Cientos de errores 404 que ya analizamos en el artículo anterior.

Si en ese top 20 no ves tus páginas importantes, tienes una fuga de crawl budget.2. El Visitante Apresurado: Googlebot llega, pero se encuentra la puerta cerrada

Googlebot intenta visitar tu URL, pero recibe un error de servidor (5xx) o de acceso (403). Es como llegar a la fiesta y que el portero no te deje entrar.

El porqué: Problemas de configuración del servidor, sobrecargas, o reglas de seguridad (WAF) demasiado agresivas que bloquean a Google.

Diagnóstico en logs: Busca errores 5xx o 403 específicamente en las visitas de Googlebot.

Bash

# Busca errores de servidor (5xx) o de acceso (403) de Googlebot

grep "Googlebot" access.log | grep " \"50[0-9] "

grep "Googlebot" access.log | grep " \"403 "

Unas pocas líneas no son un drama, pero si ves cientos, has encontrado al culpable.

3. El turista confundido: Googlebot visita la página (200 OK), pero no la indexa

Este es el más sutil. En los logs ves la visita, el código de estado es 200 OK, pero la página no aparece en Google.

El porqué:

- Contenido de baja calidad o duplicado: Google la ve, la evalúa y decide que no merece la pena incluirla en su índice.

- Soft 404: La URL devuelve un código 200 OK, pero la página tiene muy poco o ningún contenido principal (ej. una categoría sin productos que dice «No hay resultados»).

- Tiempos de carga muy altos: Googlebot tiene paciencia, pero no es infinita. Si tu servidor tarda demasiado en entregar el HTML, puede que el bot aborte antes de procesar la página completamente.

Diagnóstico en logs: Los logs no te dicen si tu contenido es bueno, pero sí te pueden dar pistas sobre la velocidad. Muchos formatos de log incluyen el tiempo de respuesta en segundos o milisegundos.

Si ves tiempos de respuesta de varios segundos para Googlebot de forma consistente, tienes un problema de rendimiento que puede estar afectando a la indexación.

El plan de acción: qué arreglar primero

- Prioridad 1: Arreglar las fugas de Crawl Budget (Primeros 3 días)

- Usa

robots.txtpara bloquear el acceso a todas las URLs con parámetros y filtros que no aporten valor SEO. - Soluciona los 404 más rastreados y las cadenas de redirecciones. Estás tapando las «goteras» para que la presión del agua llegue a las tuberías nuevas.

- Usa

- Prioridad 2: Solucionar los errores de servidor (Primera semana)

- Si tienes errores 5xx, habla con tu equipo de desarrollo o tu proveedor de hosting. No es negociable.

- Si tienes errores 403, revisa las reglas de seguridad. Asegúrate de que no estás bloqueando las IPs de Google.

- Como medida temporal, puedes reducir la velocidad de rastreo en Google Search Console para no sobrecargar el servidor mientras lo arreglas.

- Prioridad 3: Optimizar y enlazar (Continuo)

- Mejora la velocidad de carga de las páginas lentas.

- Asegúrate de que tu contenido nuevo y prioritario recibe enlaces internos desde páginas importantes de tu web (la home, páginas de categoría, etc.). No dejes tus páginas nuevas huérfanas.

Con este enfoque, dejas de jugar a las adivinanzas y empiezas a tomar decisiones basadas en datos reales. Los logs no mienten, y son la mejor herramienta para entender la relación entre tu web y el bot que, al final, paga tus facturas.